Notacja – reprezentacja – analiza

O współczesnych perspektywach wizualizacji muzyki

Zachodnia notacja muzyczna jest – jak wiadomo – mającą długą historię i szacowne osiągnięcia formą wizualizacji muzyki. Muzykę słyszymy, a notacja pozwala ją „zobaczyć” – przetłumaczyć na inną modalność sensoryczną. Jednocześnie jest sposobem na utrwalenie dzieła oraz komunikowanie, projektowanie i konstruowanie znaczenia muzycznego. Szczególnie w XX stuleciu, w odniesieniu do kompozycji o mocno niekonwencjonalnym charakterze, dzieł – jak zauważał Roman Ingarden – „dezorientujących” co do istoty muzyki w ogóle[1], notacja intensywnie ewoluowała, była udoskonalana, rozszerzana i dostosowywana do zróżnicowanych potrzeb kompozytorów i wykonawców. Dziś natomiast wyjątkowo silny wpływ wywiera na jej kształt rozwój technologii, a prawdziwym wyzwaniem są dzieła multimedialne czy hybrydyczne, które wymagają nowych, adekwatnych sposobów reprezentacji i wizualnego przedstawienia. Jednym z nich jest real-time music notation, czyli „każda notacja, zarówno tradycyjna, jak i graficzna, która jest tworzona lub przekształcana podczas rzeczywistego wykonania muzycznego”[2]. Wraz z grupą terminów pochodnych, takich jak real-time scores, virtual scores czy dynamic music notation pojęcie to dotyczy zapisu, który powstaje w czasie rzeczywistym podczas wykonania i jest wynikiem interaktywnego wpływu muzyków na kształt i ewolucję dzieła muzycznego.

Powszechność współczesnych praktyk multimedialnych przyczyniła się także do powstania ogólniejszego pojęcia animated notation, które dotyczy wszelkich prób ożywienia abstrakcyjnej grafiki dla celów notacji muzycznej[3]. W tym wypadku nie chodzi zatem o interaktywność czy też manipulowanie zapisem w czasie rzeczywistym, lecz o wizualizację służącą przede wszystkim kompozytorom i wykonawcom. Animated scores tworzone są za pomocą różnych technik i za pośrednictwem różnorodnego oprogramowania, ale posiadają zasadniczo dwa wspólne obszary zastosowania. Jednym z nich jest szeroko pojęta edukacja muzyczna, drugim – wizualizacja utworów wykorzystujących rozmaite kombinacje instrumentów (a także elektronikę) czy też dzieł, których instrumentacja jest nieokreślona lub zakłada możliwość zastosowania alternatywnych środków wykonawczych[4]. Wśród możliwych typów animowanych partytur wymienić natomiast można: scrolling scores, wspierające tradycyjne nawyki czytania partytury drukowanej i wyposażone zwykle w poruszający się kursor-wskaźnik, permutation scores skoncentrowane na zmieniającej się w czasie sekwencji zdarzeń dźwiękowych oraz transformative scores, czyli partytury o charakterze asocjacyjnym[5]. Co jednak najważniejsze, to wysunięcie na plan pierwszy komunikacyjnego aspektu takiej notacji. Nie jest ona bowiem, jak notacja tradycyjna, przeznaczona do odczytania wedle zakodowanych intencji kompozytora, lecz do indywidualnego zanalizowania i zinterpretowania, za każdym razem w inny sposób. Dla kompozytorów i wykonawców stanowi rodzaj zaproszenia do rozpoczęcia własnego, niepowtarzalnego procesu odwzorowywania atrybutów wizualnych i dźwiękowych[6]. Jeszcze innym współczesnym zjawiskiem notacyjnym jest screen score – partytura odczytywana na komputerze lub projektorze, która stanowi nie tyle wizualizację muzyki, ile pomyślaną w celach wykonawczych, zanotowaną cyfrowo kompozycję muzyczną. Partytury takie tworzy na przykład zespół nowej muzyki Decibel, używając specjalnej aplikacji ScorePlayer[7].

Przykład 1. Cat Hope, Longing (2011), partytura animowana

Nie ulega zatem wątpliwości, że problemy notacji muzycznej pozostają dziś w bezpośrednim związku z szeroko pojętymi problemami wizualizacji dźwięku i muzyki oraz cyfrowej reprezentacji danych muzycznych. Coraz częściej i coraz efektywniej różne techniki i formy wizualizacji służą też analizie muzycznej oraz badaniom akustycznym[8]. Wizualizacje takie ułatwić mogą zrozumienie struktury dzieła muzycznego (uwypuklając na przykład poszczególne motywy, rejestry czy kontur melodyczny) oraz wesprzeć słuchaczy w wychwytywaniu związków pomiędzy jej elementami, a także w postrzeganiu relacji strukturalnych na poziomie całościowej formy[9]. Niezależnie od zakresu przedstawianych parametrów muzycznych, wizualizacje takie bywają przydatne nie tylko profesjonalistom, ale też odbiorcom nieposiadającym wykształcenia muzycznego, niewtajemniczonym w zasady klasycznej notacji pięcioliniowej. Z jednej strony zatem znajdują zastosowanie w edukacji muzycznej, z drugiej – funkcjonują jako pełnoprawne prace badawcze, udanie uzupełniające tradycyjną deskrypcję analityczną lub jakąś metodologicznie wyspecjalizowaną formę analizy.

W tym miejscu warto wspomnieć jeszcze o jednym zjawisku związanym z próbami uwidocznienia muzyki – o obecnych w refleksji o muzyce od czasów starożytnych analogiach między dźwiękami lub interwałami muzycznymi a barwami wizualnymi, które aż do wieku XVIII traktowano jako metodę naukową. Za teorią powoli, aczkolwiek wytrwale szła praktyka – pod koniec XVI wieku Giuseppe Arcimboldo, mediolański malarz, poczynił pierwszy eksperyment synestetyczny, badając zgodność kolorów z dźwiękami na instrumencie muzycznym gravicembalo. W wieku XVIII Louis-Bertrand Castel zaprojektował zaś clavecin oculaire – optyczny klawesyn, który mógł wygrywać sekwencje kolorów zgodnie z instrukcją: „Chcesz niebieskiego? Połóż palec na pierwszym klawiszu z lewej strony. Chcesz tego samego, tylko stopień jaśniejszego – dotknij ósmego klawisza. Chcesz dwa stopnie jaśniej – dotknij piętnastego…”[10]. W rezultacie w tej samej chwili, gdy rozbrzmiewał dźwięk, widać było też kolor. Im bardziej przesuniemy się na osi czasu wprzód, tym przykładów instrumentów zdolnych odgrywać „muzykę kolorów” znajdziemy więcej, aż dotrzemy do dwudziestowiecznych koncepcji łączenia projekcji barwnych i świetlnych z muzyką (np. Skriabinowski Prometeusz na orkiestrę, chór organy świetlne czy politopy Xenakisa, ale też pokazy laserowe i gra świateł na koncertach muzyki pop).

Rzecz jasna, wizualizacja muzyki stawała się łatwiejsza wraz ze wzrastającą popularnością komputerów i przyrostem stosowanego oprogramowania. Nie dotyczy to wyłącznie możliwości mapowania dźwięków i kolorów – gdy na początku lat 90. zaprezentowano na przykład przetwarzanie zakodowanych w DARMS[11] partytur muzycznych na wykresy graficzne różnego typu (ukazujące dystrybucję wysokości dźwięku w czasie czy też charakterystyki rytmiczne i dynamiczne tych utworów[12]), nie przypuszczano zapewne, że niebawem będzie to idea powszechnie dostępna, niewymagająca ani specjalnego hardware’u, ani możliwego do opanowania tylko przez specjalistów software’u. Dążenie do przedstawiania i uwypuklania danych muzycznych za pomocą różnego rodzaju reprezentacji graficznych wygenerowanych przez komputer okazało się tendencją trwałą, systematycznie rozwijaną i udoskonalaną. Współczesna technologia daje naprawdę ogromne i różnorodne możliwości wizualizowania muzyki, od prostych realizacji zasady „widzisz to, co słyszysz”, po złożone wglądy w strukturę. Powstają też bogate repozytoria wizualizacji, które zostały stworzone za pomocą mniej lub bardziej skomplikowanych narzędzi komputerowych.

Jeden z największych tego typu zbiorów związany jest z Music Animation Machine (MAM), rozwijanym od połowy lat 80. ubiegłego stulecia projektem Stephena Malinowskiego, amerykańskiego kompozytora, pedagoga i wynalazcy. Efekty swojej pracy zamieszcza on m.in. na swoich kanałach YouTube, wypracowując rozmaite sposoby przekładania dźwięków muzycznych na znaki graficzne[13]. Zamiast konwencjonalnych symboli, jego animowane partytury składają się z kolorowych elementów reprezentujących nuty. W najprostszej postaci wizualizacji usytuowanie wertykalne każdego takiego elementu oznacza wysokość dźwięków, horyzontalne – jego czas trwania w odniesieniu do innych dźwięków. Znaki te przesuwają się na ekranie w miarę odgrywania utworu, a brzmiące w danym momencie dźwięki wraz ze swymi graficznymi odpowiednikami zostają podświetlone[14]. MAM nazywany jest przez autora „GPS-em dla muzyki”, gdyż stanowi dynamiczny system podkreślający te jej cechy, które są ważne w danym czasie i jest swego rodzaju przewodnikiem po utworach muzycznych. Ukazuje on czasem szczególnie interesująco takie cechy struktury muzycznej, które niełatwo zauważyć podczas śledzenia partytury, a także nie są dostępne w doświadczeniu słuchowym, tzn. na przykład rozmaite symetrie i korespondencje między grupami dźwięków[15].

Przykład 2. Animacja do Canon 4 a 2 per Augmentationem, contrario Motu

z Musikalisches Opfer J. S. Bacha

Malinowski animuje głównie utwory muzyki klasycznej, ale sięga też czasem po bardziej współczesny repertuar i angażuje się w tworzenie prezentacji wizualnych do muzyki wykonywanej na żywo podczas najróżniejszych koncertów. Animacje Malinowskiego wspomogły na przykład islandzką piosenkarkę Björk na trasie koncertowej z nowym albumem Vulnicura – występowi w Carnegie Hall w Nowym Jorku akompaniowały animowane notacje każdego utworu, które zawierały także fragmenty śpiewanego tekstu. Najbardziej skomplikowaną partyturą zaanimowaną przez Malinowskiego jest, jak dotąd, Święto wiosny Igora Strawińskiego. Część wielu problemów związanych z odwzorowaniem własności tej wielowarstwowej muzyki rozwiązał autor poprzez zastosowanie odpowiednich kształtów graficznych (dla różnych grup instrumentów) i zróżnicowanie ich kolorystyki w celu zilustrowania zmian harmonicznych i tonalnych (zastosowano 12 kolorów odpowiadających poszczególnym wysokościom w porządku koła kwintowego). W ramach projektu MAM przedstawione zostały także na przykład arcyciekawe animacje zbioru Studies for Player Piano Conlona Nancarrowa.

Celom pedagogicznym wydatnie służy także zbiór muzycznych wizualizacji zebrany w bibliotece cyfrowej Philharmonie de Paris. Owe „interaktywne przewodniki słuchania” (guides d’écoute interactif) obejmujące różne gatunki muzyki (od „klasyki” po muzykę współczesną, tradycyjną, jazz i popularną), wykonane zostały za pomocą stworzonego przez Oliviera Koechlina oprogramowania MetaScore. Program ten jest udostępniany francuskim nauczycielom i badaczom przez Philharmonie de Paris. Wizualizacje generowane za jego pomocą służyć mają lepszemu poznaniu i zrozumieniu własności oraz struktury dzieł muzycznych uwidocznionych zwykle w sposób złożony – nie tylko za pośrednictwem dwuwymiarowej grafiki, ale też wyjaśniającego tekstu, zsynchronizowanej z nagraniem partytury czy filmu wideo rejestrującego dane wykonanie, na przykład arii z Orfeusza Monteverdiego. Z kolei słuchając Danse sacrale ze Święta wiosny Strawińskiego, można obserwować zderzenia i wzajemne uzupełnienia bloków brzmieniowych budowanych z grup instrumentów rozszerzonej orkiestry, a przy okazji – budowę formalną całej tej części baletu. Wszystkie przewodniki opublikowane w paryskiej mediatece zawierają takie syntetyczne prezentacje podziału formalnego analizowanego utworu. Wreszcie, MetaScore umożliwia śledzenie partytury, po której synchronicznie do odtwarzanej muzyki porusza się kursor. Synchronizacji nagranie–partytura jest w omawianym repozytorium bardzo wiele, nie wszystkie jednak są publicznie dostępne, podobnie zresztą jak i samo oprogramowanie.

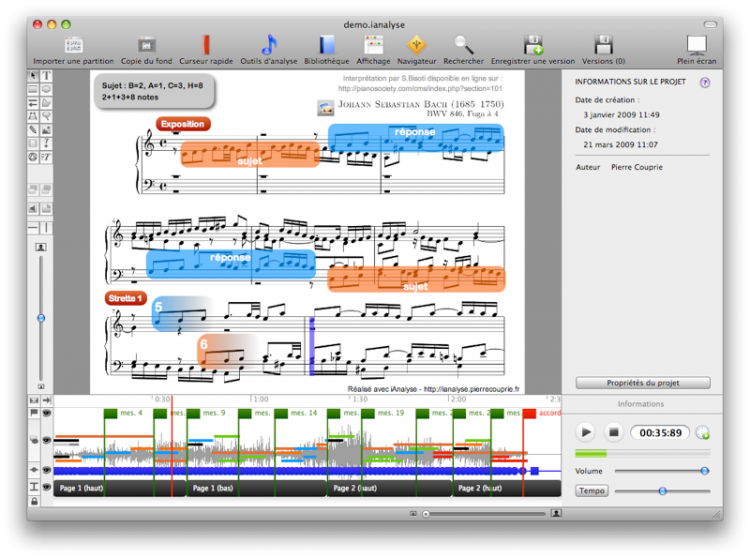

Istnieje jednak niekomercyjne narzędzie komputerowe, które pozwala na samodzielne wykonanie analogicznych synchronizacji. Jest nim iAnalyse, program opracowany przez Pierre’a Couprie’go[16], za pomocą którego połączymy zeskanowaną partyturę z plikiem audio lub wideo, a na partyturze poczynimy pożądane adnotacje. Pierwszą publiczną wersję programu udostępniono w 2006 roku i od tego czasu iAnalyse, przeznaczony dla komputerów Mac, został udoskonalony do wersji czwartej. Jest on systemem koordynującym wszystkie elementy graficzne (w tym zeskanowane partytury) na ścieżce audiowizualnej. W rezultacie powstać może dostosowany do różnych celów i zróżnicowanych grup odbiorców „przewodnik słuchowy” albo też analiza muzykologiczna, odnosząca się do wybranych własności muzyki zapisanej za pomocą notacji pięcioliniowej. W iAnalyse zjawiska dźwiękowe można przedstawiać również na wykresie fali dźwiękowej i na spektrogramie (będącym formą reprezentacji czasowo-częstotliwościowej muzyki) oraz tworzyć wielopoziomowe schematy konstrukcyjno-formalne dla danego utworu, swego rodzaju analityczne segmentacje powstające podczas słuchania. Spośród przykładów zastosowania iAnalyse wyróżnijmy zamieszczoną na kanale twórcy tego oprogramowania analizę muzyki Weberna (Zehr ruhig und zart z Pięciu utworów na orkiestrę op. 10) oraz czterogłosowej fugi Bacha z I tomu WTK (C-dur, BWV 846). Obydwie ukazują budowę formalną kompozycji podczas ujednocześnionej prezentacji nagrania i partytury. Sieć wyjaśniających komentarzy tekstowo-graficznych uwydatnia i tłumaczy funkcje poszczególnych elementów formy, co w pierwszym rzędzie przywodzi na myśl zastosowania pedagogiczne.

Przykład 3. J. S. Bach, Fuga C-dur BMV 846, wizualizacja w iAnayse

Z programu iAnalyse wyrósł kolejny produkt Pierre’a Couprie’go – narzędzie komputerowe nazwane EAnalysis, którego działanie opiera się zasadniczo na takich samych zasadach, jak iAnalyse, ale ich realizacja jest bardziej złożona, gdyż program przeznaczony jest do analizy przedmiotów dźwiękowych w muzyce elektroakustycznej. W punkcie wyjścia wzorcem dla autora był stworzony w Ina GRM[17] program Acousmographe, który uzupełnia obraz widma utworu o elementy graficzne. Oprogramowanie to przydatne jest do opisywania, analizowania i reprezentowania wszelkiej muzyki „nietradycyjnej”, w szczególności takiej, która nie nadaje się do konwencjonalnego zapisu (np. etniczna, jazzowa, improwizowana). Począwszy od lat 80. rozwijane było jednak zwłaszcza z myślą o muzyce elektroakustycznej. W 2004 roku zaprezentowano trzecią wersję zaprojektowaną specjalnie na zamówienie francuskiego Ministerstwa Edukacji – nacisk położono na łatwość użycia, ponieważ celem Ministerstwa było udostępnienie Acousmographe w szkołach jako narzędzia nauczania. Możliwość wizualizacji sygnału dźwiękowego na spektrogramie, słuchania w zwolnionym tempie oraz wielość narzędzi graficznych sprawiają, że wykonane w tym programie prezentacje mogą być dość wyrafinowane. Na przykład w analizie początkowego odcinka (Prosopopée 1) Symphonie pour un homme seul Pierre’a Schaeffera i Pierre’a Henry’ego, jej autorka – Fanny Rebillard – odwołała się do rozmaitych kształtów i kolorów, by szczegółowo zlokalizować wszystkie wystąpienia przedmiotów dźwiękowych obecnych w tej sekwencji utworu.

Przykład 4. Prosopopée 1 z Symphonie pour un homme seul P. Schaeffera i P. Henry’ego, analiza i transkrypcja w Acousmographe

Z udziałem Acousmographe powstała też multimedialna seria publikacji Ina GRM pt. Les Portraits Polychromes, dedykowana wybitnym przedstawicielom muzyki elektroakustycznej, jak Pierre Schaeffer, Denis Smalley, Jean-Claude Risset, François Bayle czy Bernard Parmegiani i ich kompozycjom. Jest to swego rodzaju kolekcja graficznych transkrypcji dzieł elektroakustycznych czy też „przewodników słuchowych” po ich utworach.

Natomiast EAnalysis Pierre’a Couprie’ego poprawia możliwości programu Acousmographe poprzez zastosowanie narzędzi analitycznych badających wybrane parametry akustyczne i możliwość pracy z innymi typami danych[18]. EAnalysis, tak jak Acousmographe, ukazuje spektrogram i falę dźwiękową dla danego nagrania, ale można do niego importować także kilka plików audio i wideo jednocześnie, by porównywać różne utwory lub analizować dzieła wielościeżkowe. Ponieważ oprogramowanie współpracuje z materiałami wideo, nadaje się do analizy nowych mediów, na przykład instalacji dźwiękowych, pejzażu dźwiękowego oraz muzyki filmowej, czego przykłady znajdziemy w reklamującym możliwości programu pokazie slajdów na domowej stronie projektu (np. analityczne wizualizacje struktury dźwiękowej fragmentów filmów Słoń Gusa Van Santa i Kill Bill Quentina Tarantino czy też mapa „spaceru dźwiękowego”). W ten sposób narzędzie stworzone przez Couprie’ego wprowadza w nowe – albo przynajmniej niewyeksploatowane dotąd dostatecznie w muzykologii – obszary badawcze. Nie proponuje dla nich uniwersalnego modelu poznawczego, ale pozwala tworzyć opisy analityczne równie wielomodalne, jak multimedialna jest badana materia – łączy tekst, grafikę, obrazy, mowę, muzykę i animację w celu tłumaczenia heterogenicznych zjawisk będących przedmiotem zainteresowania współczesnej nauki o muzyce.

Przykład 5. Fragment filmu Słoń Gusa van Santa, wizualizacja analityczna w EAnalysis

Zasadniczym celem autora było bowiem stworzenie narzędzia, które umożliwia badaczowi poruszanie się ponad ograniczeniami ujęcia dwuwymiarowego, czasowo-częstotliwościowego. EAnalysis daje zatem możliwość przeprowadzenia analizy na podstawie różnych parametrów lub parametrów w różnych warstwach oraz ułatwia dostosowanie takiej prezentacji do własnych strategii analitycznych, dzięki różnym typom reprezentacji graficznej (np. macierzom podobieństwa, diagramom korelacji, diagramom formalnym). Program pracuje w trybie „normalnym” – wtedy można dodawać (techniką „przeciągnij i upuść”) do ekranowego widoku określone zdarzenia analityczne i odpowiadające im elementy graficzne (implementowana jest ich bogata biblioteka). W trybie tekstowym można wówczas sporządzać rozmaite adnotacje, w trybie rysowania – zdefiniować własne jakości graficzne, szczególnie gdy posługujemy się tabletem graficznym, a w trybie odtwarzania – wykorzystać podczas prezentacji. Przyjęte parametry analityczne modyfikują rodzaj reprezentacji, podobnie jak arkusze stylów w komputerowych edytorach tekstu. Na koniec wyniki pracy można eksportować do różnych formatów: obrazów, plików PDF, plików wideo, plików tekstowych czy XML.

Przykładowy efekt pracy z EAnalysis ukażmy na podstawie analizy początku NoaNoa Kaiji Saariaho[19]. Składa się ona z widoku spektrogramu, partytury i schematu paradygmatycznego. Fragmenty spektrogramu ujęte w kwadratowych blokach odpowiadają tu podstawowym jednostkom semiotycznym – elementom dźwiękowym podlegającym dystrybucji. Na osi poziomej prezentowane są bowiem w rzędach trzy rodzaje jednostek identycznych lub podobnych, opatrzone odpowiednimi analitycznymi oznaczeniami literowymi (A, B i C). Po wybraniu bloku można odtworzyć dany wycinek muzyki albo podczas odtwarzania całego utworu obserwować, który blok znajduje się aktualnie w obszarze przesuwającego się kursora, w tym samym czasie mając też wgląd w partyturę.

Przykład 6. Kaija Saariaho, NoaNoa, wizualizacja analityczna w EAnalysis

Więcej reprezentatywnych analiz znaleźć można na kanale YouTube autora, w tym impresywnie zwizualizowaną całość Sud Jeana-Claude’a Risseta, jednego z pionierów muzyki komputerowej. Wynikiem działania EAnalysis jest zsynchronizowany z muzyką pokaz slajdów w formacie wideo, ale możliwy jest też eksport takiej prezentacji bez mediów, by ominąć ewentualne restrykcje związane z prawem autorskim.

Wśród programów wizualizujących muzykę wymienić trzeba jedną jeszcze ciekawą ich odmianę, którą reprezentuje Sonic Visualizer, opracowany przez Chrisa Cannama. Jest to konfigurowalne narzędzie do analizy muzyki nagranej, którego szczególnie atrakcyjną własnością jest opcja badania różnych wykonań tego samego utworu. U podstaw programu leży istotna idea metodologiczna – przesunięcie uwagi badawczej z dzieła (badanego na podstawie partytury) na jego wykonanie reprezentowane przez nagranie. Wizualizacja służy temu celowi wydatnie, gdyż tradycyjna analiza oparta na partyturze wyklucza wszystkie retoryczne czy ekspresyjne efekty związane z wykonaniem, pozostające zresztą w dość luźnym związku ze strukturą muzyki, która zwykle najbardziej interesuje tradycyjnie zorientowanego badacza. Daje to możliwość skoncentrowania się na kwestiach tempa, problemów dynamiki czy barwy dźwięku[20].

Zasada działania programu opiera się na wizualizowaniu muzyki w nakładanych na siebie warstwach, a dostępne wtyczki wspomagają konkretne zadania analityczne, ułatwiając na przykład wykrywanie punktów ataku dźwięków, określanie ich wysokości czy intensywności. Wyniki działania tych funkcji ukazują się zwykle w postaci rozmaitych wykresów i pasków segmentujących. Sonic Visualizer korzysta zatem z potencjału Music Information Retrieval[21] – interdyscyplinarnego obszaru, na którym spotykają się algorytmy komputerowe pozwalające na „usłyszenie” i „zrozumienie” danych audio. Najprościej rzecz ujmując, podobnie jak człowiek rozpoznaje takie własności muzyki jak tempo, następstwa akordowe czy budowa formalna, tak algorytmy są w stanie rozpoznać i wydzielić podobne informacje z pliku dźwiękowego. Jedną z ciekawych opcji programu jest wtyczka operująca algorytmem wychwytującym tonalne i melodyczne własności muzyki, niezależnie od jej barwy i instrumentacji. Ów tzw. chromagram jest implementacją modelu percepcyjnego, ukazującego rozkład energii sygnału muzycznego w 12 pasmach korespondujących z tradycyjnymi 12 klasami wysokości dźwięku w ramach oktawy, w którym waga poszczególnych wysokości (i ich słyszalność) oddana jest poprzez kolorystykę. Na przykład, o ile na konwencjonalnym spektrogramie widoczne są linie ukazujące dźwięki budujące dany trójdźwięk wraz ze swymi alikwotami, o tyle na chromagramie bez trudu zidentyfikujemy poszczególne (trzy) elementy akordowe. Jedną z dostępnych wtyczek jest też Segmenter, który dzieli muzykę na spójne pod względem strukturalnym segmenty. Jeśli posiada ona wyraźnie różniące się od siebie pod względem tonalnym sekcje, to należy spodziewać się, że w wyniku działania algorytmu zostaną znalezione i oznaczone wszystkie segmenty do siebie podobne, co wspomaga tym samym analizę budowy formalnej dzieła muzycznego.

Przykład 7. Spektrogram (na dole) i chromagram kadencji wielkiej doskonałej w tonacji C-dur, zwizualizowany w Sonic Visualizer

Jak już wspomniano, w pracy z nagraniami użyteczna jest szczególnie zdolność Sonic Visualizera do porównywania danych. Za pomocą wtyczki MATCH można badać jednocześnie dwa nagrania. Algorytm znajduje ścieżkę koordynacji, która łączy każdy moment w jednym pliku z określonym momentem w drugim tak, by zachowany został czasowy porządek tych momentów i wyeksponowane zostało podobieństwo barwowe między odpowiadającymi sobie momentami. W rezultacie zaznaczenie w jednym pliku dźwiękowym miejsca odpowiadającego na przykład drugiemu taktowi danego utworu pozwala przejść do analogicznego punktu drugiego i kolejnego nagrania.

Przykład 8. Porównanie dwóch różnych nagrań do wspólnego punktu odniesienia w Sonic Visualizer. Za: A musicologist’s guide to Sonic Visualiser…

Nie ulega wątpliwości, że różne formy wizualizacji muzyki służą dziś zróżnicowanym celom: od pokrewnego funkcji notacji tradycyjnej (utrwalającego, wspomagającego pamięć, będącego podstawą komunikacji między twórcą a wykonawcą i odbiorcą, tworzącego „tekst” przeznaczony do interpretacji), po analityczny (wizualizacja stanowi wówczas medium do demonstrowania odkrytych w procesie badawczym praw muzycznych czy akustycznych) oraz edukacyjny. Nie sposób orzec, który z tych trendów ma znaczenie nadrzędne, gdyż najczęściej – czego dowodzi powyższy przegląd możliwości – wchodzą one we wzajemne relacje. Tak czy inaczej, wszystkie rodzaje wizualizacji muzyki znacznie wzbogacają doświadczenie słuchowe, dając z jednej strony „wyostrzony” obraz tego, co słyszymy, a z drugiej – ułatwiając wychwytywanie w tym, co słyszymy, określonych prawidłowości.

Iwona Lindstedt

[1] Zob. Roman Ingarden, Twórcze zachowanie autora i współtworzenie przez wirtuoza i słuchacza, w: tegoż, Studia z estetyki, t. 3, PWN, Warszawa 1970, s. 147.

[2] Arthur Clay, Jason Freeman, Preface: Virtual scores and real-time playing, „Contemporary Music Review”, vol. 29, no. 1, 2010, s. 1, tłum. własne.

[3] Zob. Christian M. Fischer, Understanding animated notation, referat na First International Conference on Technologies for Music Notation and Representation, TENOR, Paris 2015.

[4] Tamże, s. 2.

[5] Systematyka Lindsay Vickery, zaproponowana w: tejże, The Evolution of Notational Innovations from Mobile Score to Screen Score „Organized Sound”, vol. 17(2), 2012.

[6] Tamże.

[7] Zob. np. Cat Hope, Lindsay Vickery, The Decibel Score Player – A Digital Tool for Reading Graphic Notation, w: Proceedings of First International Conference on Technologies for Music Notation and Representation, TENOR, Paris 2015, s. 58–69.

[8] Pełny zakres problematyki odzwierciedlają programy międzynarodowy edycji konferencji TENOR, poświęconej technologii, notacji i reprezentacji w muzyce, zob. http://www.tenor-conference.org.

[9] Wykorzystanie grafiki do wyeksponowania analitycznych aspektów dzieła muzycznego ma dość długą historię – za początek można przyjąć diagramy Alfreda Lorenza ukazujące schemat modulacyjny w Pierścieniu Nibelunga Wagnera (1924) , w: tegoż, Das Geheimnis der Form bei Richard Wagner, 1924, t. 4, edycja faksymilowa, Tutzing 1966.

[10] Tegoż, Esprit, saillies, et singularités du Père Castel (1763). Na temat instrumentu, zob. też: Maarten Franssen, The Ocular Harpsichord of Louis-Ber-trand Castel, „Tractrix”, vol. 3, 1991, s. 15–77.

[11] Akronim powstałego już w 1963 roku języka kodowania muzyki pn. Digital Alternate Representation of Musical Scores.

[12] Zob. Alexander R. Brinkman, Martha R. Mesiti, Computer-Graphic Tools for Music Analysis, w: Proceedings of the 1991 International Computer Music Conference, Michigan Publishing 1991, s. 53–56.

[13] Pełne ich spektrum prezentuje Malinowski na swej stronie internetowej: www.musanim.com/background.

[14] Malinowski udostępnia prosty program komputerowy Music Animation Machine MIDI Player, dzięki któremu można samodzielnie wizualizować pliki MIDI na kilka implementowanych przez autora sposobów. Zob. www.musanim.com/player.

[15] Zob. animacje fortepianowych Wariacji op. 27 Weberna czy Wariacji Goldbergowskich Bacha.

[16] Zob. http://logiciels.pierrecouprie.fr/?page_id=672; http://logiciels.pierrecouprie.fr/?page_id=534.

[17] Jednostka Francuskiego Instytutu Audiowizualnego (Institut National Audiovisuel) zajmująca się badaniami nad dźwiękiem i muzyką elektroakustyczną (Musical Research Group – GRM).

[18] EAnalysis został stworzony w celu wypełnienia luki w istniejących aplikacjach analitycznych. Program nie może robić wszystkiego, czego muzykolodzy, nauczyciele lub muzycy by sobie życzyli – jest to przestrzeń robocza, w której użytkownik tworzyć może rozmaite reprezentacje, importować dane z innego oprogramowania lub te zarejestrowane podczas wykonania oraz je analizować. „Nie wynalazłem ponownie koła; ten program daje możliwość importowania danych i eksportowania analiz w różnych formatach” – komentuje Pierre Couprie. Zob. tegoż, EAnalysis: developing a sound-based music analytical tool, w: red. Leigh Landy i Simon Emmerson, Expanding the Horizon of Electroacoustic Music Analysis, Cambridge University Press, Cambridge 2016, s. 170–194.

[19] W: P. Couprie, EAnalysis: developing a sound-based music…, dz. cyt., s. 180.

[20] O metodach analizowania nagrań pisze zajmująco Nicholas Cook. Zob. tegoż: Methods for analysing recordings, w: red. Nicholas Cook, Eric Clarke, Daniel Leech-Wilkinson, John Rink, The Cambridge Companion to Recorded Music, Cambridge University Press, Cambridge–New York–Berkeley 2009, s. 221–245.

[21] Zob. na przykład www.ismir.net, http://musicinformationretrieval.com.